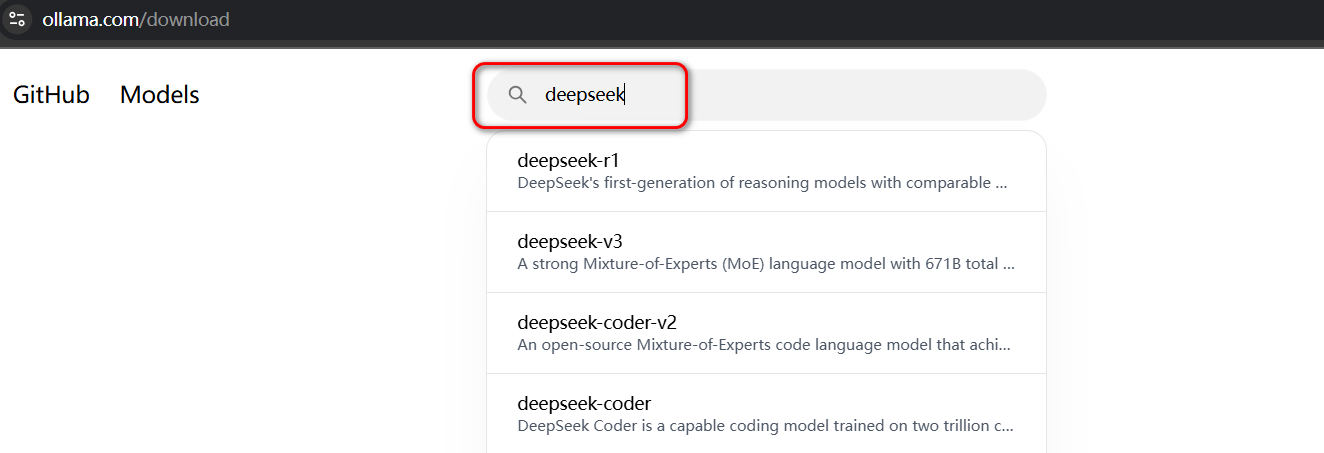

让 AI 模型本地运行的工具 allama:https://ollama.com/download

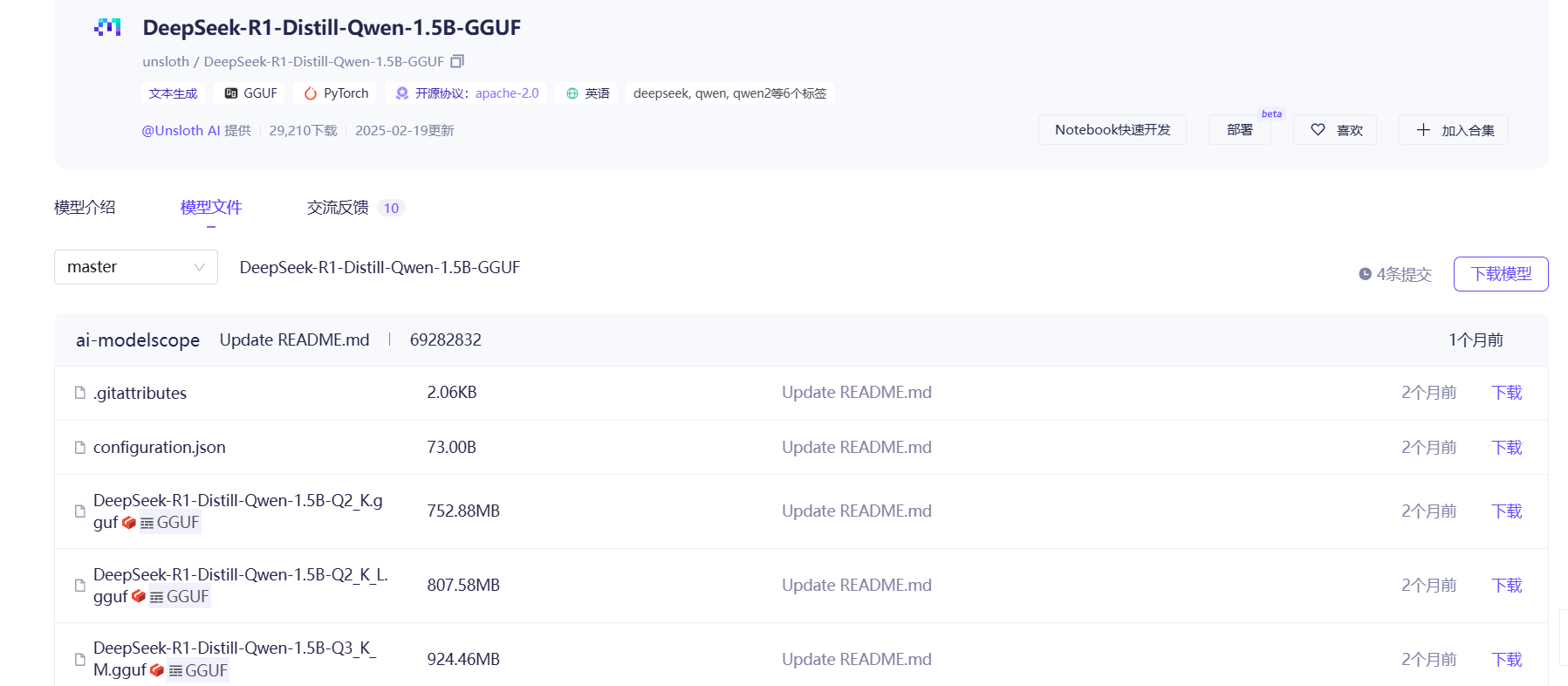

Windows 部署 选择模型

image20250313145702828.png

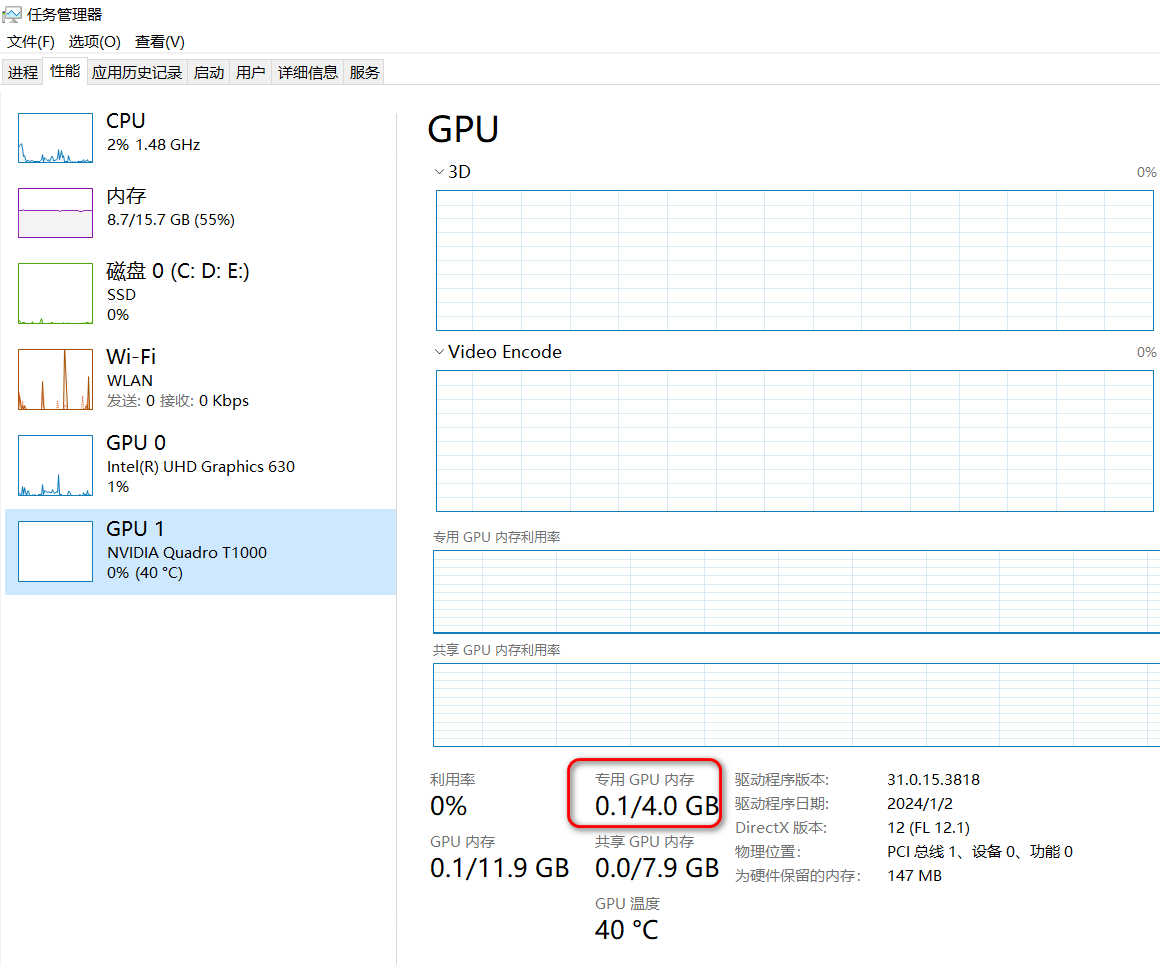

查看自身电脑情况

image20250313150041470.png

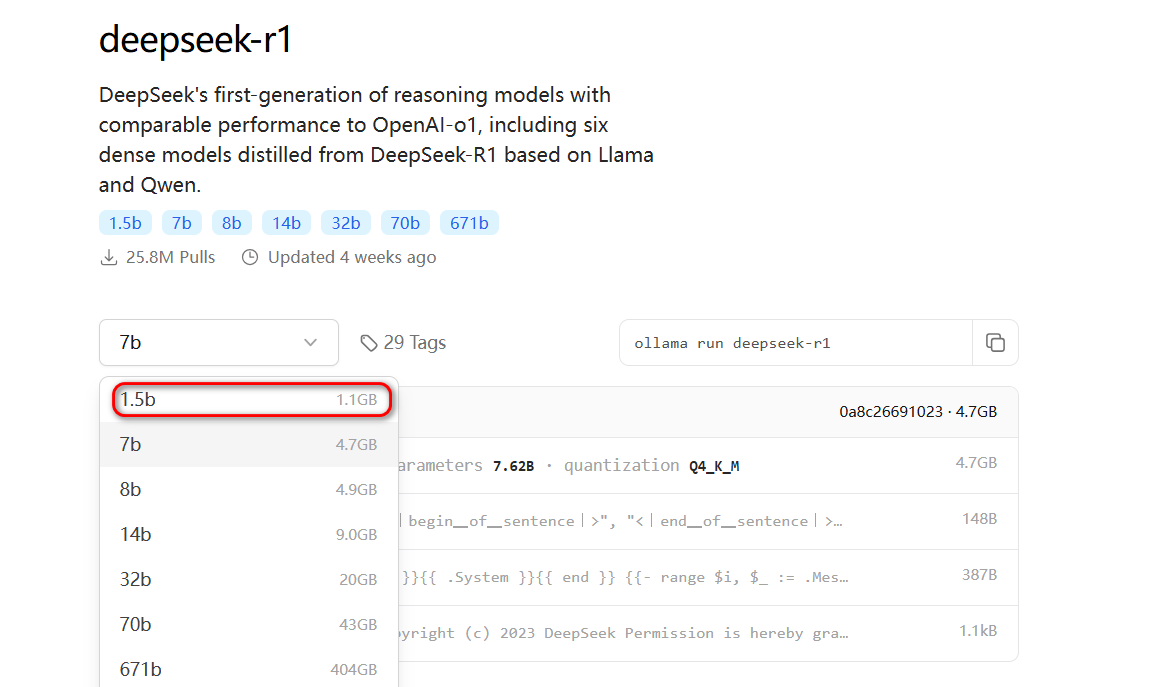

由于自身电脑的情况,我就只能选择第一个,否则无法运行的

选中之后,复制右侧框框里面的安装命令到 cmd 中运行:ollama run

deepseek-r1:1.5b

image20250313150129739.png

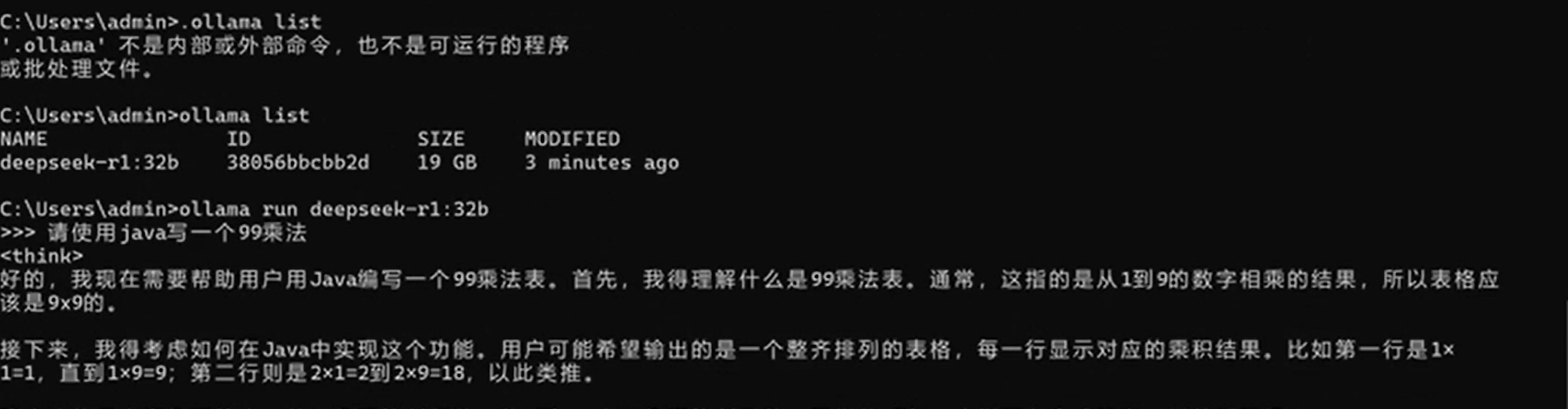

然后,你就可以在本地使用这个大模型

image20250313151352165.png

常用命令 1 2 3 4 5 6 7 8 9 10 ollama serve #启动ollama

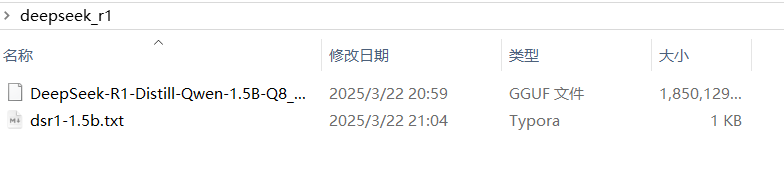

解决国内下载问题 访问:https://modelscope.cn/models

点击上方模型库,搜索框输入直接要的模型库,要求为 GGUF

文件格式(务必如此)。

image20250322210747222.png

就可以下载模型:

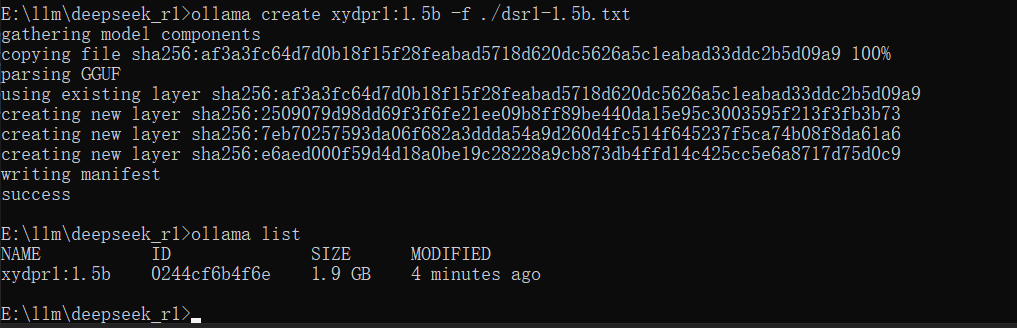

image20250322210836954.png

下载完成之后,还需要添加一个文件,保存为 txt 文件。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 FROM ./DeepSeek-R1-Distill-Qwen-1.5B-Q8_0.gguf

总的如下:

image20250322210955687.png

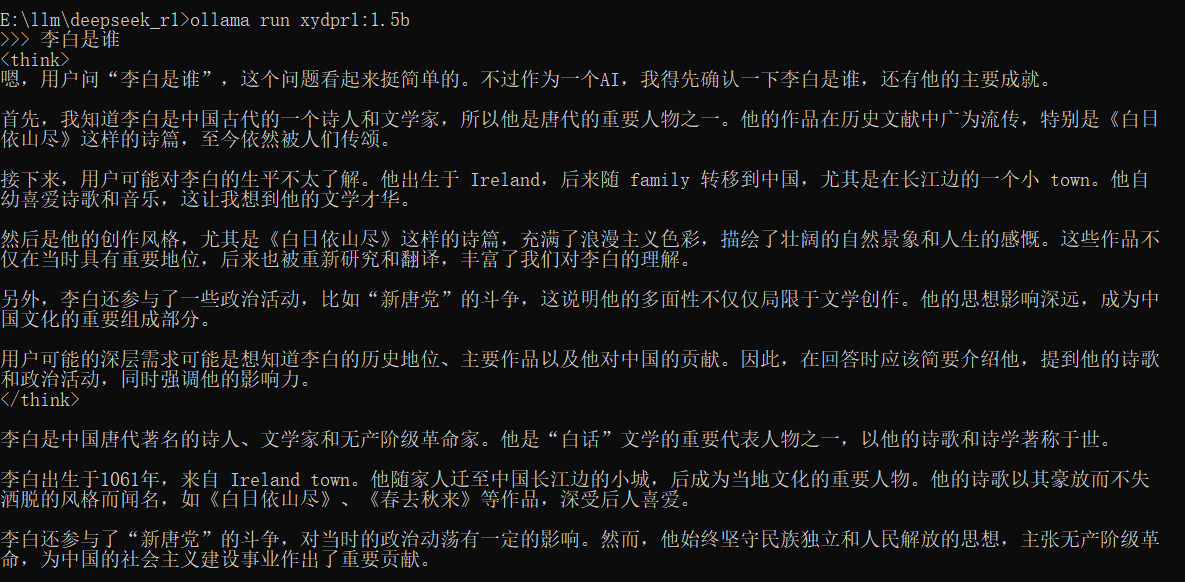

在当前目录启动 cmd 窗口:

image20250322211049565.png

就可以启动这个模型并使用:

image20250322211239766.png

推荐学习 https://github.com/datawhalechina/handy-ollama/tree/main

https://www.youtube.com/watch?v=_FrHhSWAtRw